NVIDIA宣布对 NeMo Megatron 框架进行更新,该框架可将大型语言模型的 AI 训练速度提高 30%。

NVIDIA AI 平台为大型语言模型带来巨大收益,速度提升 30%

新闻稿: 随着大型语言模型 (LLM) 的规模和复杂性不断增长,NVIDIA 今天宣布对 NeMo Megatron 框架进行更新,该框架可提供高达 30% 的训练速度提升。

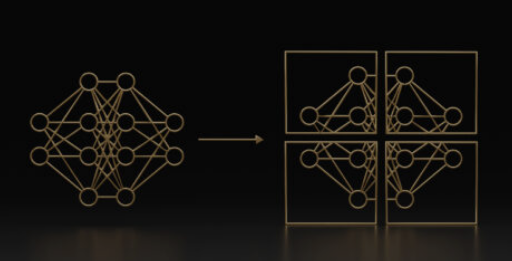

这些更新包括两项开创性技术和一个超参数工具,可在任意数量的 GPU 上优化和扩展 LLM 的训练,提供使用 NVIDIA AI 平台训练和部署模型的新功能。

BLOOM是世界上最大的开放科学、开放获取的多语言语言模型,拥有 1760 亿个参数,最近在 NVIDIA AI 平台上进行了训练,支持 46 种语言和 13 种编程语言的文本生成。NVIDIA AI 平台还支持拥有 5300 亿个参数的最强大的 Transformer 语言模型之一,即Megatron-Turing NLG 模型(MT-NLG)。

LLM 是当今最重要的先进技术之一,涉及从文本中学习的多达数万亿个参数。然而,开发它们是一个昂贵且耗时的过程,需要深厚的技术专长、分布式基础设施和全栈方法。

NVIDIA 为大型语言模型 2 提供高达 30% 的 AI 性能提升

适用于 Tesla V100 SXM3 GPU 的 NVIDIA HGX 2 GPU(图形处理单元)托盘环。该公司的 HGX 基板与其 A100 Tensor Core GPU 配对,一些人担心如果 NVIDIA 收购设计公司,Arm 产品可能会面临类似的命运。图片:浪潮集团

然而,它们在推进实时内容生成、文本摘要、客户服务聊天机器人和对话式 AI 界面问答方面的好处是巨大的。

为了推进 LLM,AI 社区正在继续对Microsoft DeepSpeed、Colossal-AI和Hugging Face BigScience等工具进行创新,这些工具均由 NVIDIA AI 平台提供支持,包括Megatron-LM、Apex和其他 GPU 加速库。